Die künstliche Intelligenz ist heute allgegenwärtig und dehnt sich fortwährend auf weitere Bereiche der Wirtschaft aus. So zum Beispiel im Verkehrswesen, Vertrieb oder der industriellen Produktion. 2024 soll, wie das Marktforschungsinstitut Gartner prognostiziert, diese auf 5,1 Billionen Dollar anwachsen. Nicht zuletzt ist es derzeit auch ein intensiv behandeltes Forschungsgebiet an vielen Universitäten und Hochschulen weltweit.

Die künstliche Intelligenz kommt dabei auch in zunehmend mehr Bereichen der Medizin zum Einsatz. Die Anwendungsbereiche sind vielfältig und betreffen u. a. die Medikamentenforschung, Diagnostik oder auch Behandlungsmethoden. Die moderne medizinische Diagnostik zum Beispiel, zeichnet sich durch eine umfangreiche Unterstützung bildgebender Verfahren aus. Dazu zählen u. a. Röntgenaufnahmen, Computertomographie (CT), Magnet-Resonanz-Tomographie (MRT) oder die Endoskopie.

Durch den Einsatz von Deep Learning ergibt sich dadurch ein weites Anwendungsfeld. Dabei hat die KI gestützte Medizin nicht das Ziel, einen Arzt zu ersetzen. Vielmehr wird den Medizinern eine zusätzliche Interpretationshilfe gegeben, die einen anderen Blickwinkel ermöglicht.

Ziel ist in erster Linie eine Steigerung der Effizienz und Effektivität der Untersuchung.

Im Folgenden wird dies exemplarisch am Beispiel der Glaukom Diagnose veranschaulicht.

Dazu werden drei Beiträge erscheinen, welche folgende Themenschwerpunkte setzen:

- Teil 1 beschreibt das Glaukom, die Grundlagen des Deep Learnings sowie Neuronaler Netze.

- Teil 2 handelt von den Grundlagen der Convolutional Neural Networks und den Ansätzen bei der Glaukom Erkennung.

- Teil 3 beschreibt die Erkenntnisse durch die Evaluation der Ergebnisse.

Das Glaukom

Das Glaukom oder im Volksmund auch „Grüner Star“, ist eine degenerative Augenerkrankung, die primär den Sehnerv des Auges befällt, und unbehandelt zur vollständigen Erblindung führt. Dabei ist das Glaukom global gesehen einer der am häufigsten Augenerkrankungen, die in allen Altersgruppen vorkommt, jedoch gerade bei älteren Menschen gehäuft auftritt. Schon der berühmte griechische Arzt Hippokrates beschreibt das „Glaykoseis “ als eine im hohen Alter eintretende Erblindung. Die Erkrankung verläuft dabei meist schleichend, wobei der Sehnerv fortwährend irreversibel degeneriert.

Tückisch ist zudem das, das Glaukom meist erst sehr spät erkannt wird, was mit beträchtlichen Ausfällen des Gesichtsfeldes einhergeht.

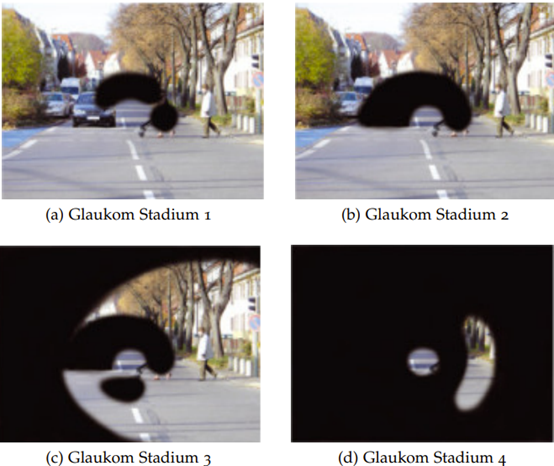

Das folgende Bild zeigt dabei typische Stadien bei einer Glaukom Erkrankung. Bemerkenswert an dieser Stelle ist, dass häufig eine Diagnose erst in Stadium 3 erfolgt. Zu dem Zeitpunkt sind meist schon 60-70% Prozent der Sehnervenzellen unwiederbringlich zerstört.

Diese Art der Gesichtsfeldausfälle (Bjerrum Skotom) bilden sich meist halbkreisförmig, ausgehend vom blinden Fleck und werden zu Beginn der Erkrankung mitunter durch die Fähigkeiten des Gehirns in der Wahrnehmung des Menschen korrigiert. Dies führt auch dazu, dass Menschen erst sehr spät eine Einschränkung des Sehens bemerken, und ärztlichen Rat aufsuchen. Das Glaukom kann bei einer Erkennung heutzutage mit diversen Therapieansätzen behandelt werden, aber in seinem Krankheitsverlauf nur gestoppt bzw. sehr stark verlangsamt werden. All dies macht es notwendig, die Erkrankung in möglichst frühen Stadien zu erkennen und zu behandeln.

Typische Symptome einer Glaukom Erkrankung sind neben den Ausfällen im Gesichtsfeld häufig Kopfschmerz, Übelkeit oder ein plötzlicher Sehkraftverlust. Dabei sind typische Risikofaktoren für ein Glaukom Rauchen, Diabetes Mellitus, Bluthochdruck, niedriger Blutdruck, Migräne und vor allem ein erhöhter Augeninnendruck.

Gerade der Augeninnendruck wurde früher sogar als das maßgebliche Diagnosemerkmal gesehen. Allerdings hat sich in der modernen Medizin die Erkenntnis durchgesetzt, dass der Augeninnendruck als hauptsächliches Diagnosemerkmal nicht aussagekräftig genug ist. So haben rund 40% der Glaukomerkrankten keinen erhöhten Augeninnendruck. Dennoch wird heute z.B. neben dem Cup-Disc Verhältnisses, oder der fachärztlichen Bewertung von Aufnahmen des Augapfels, der Messung des Augeninnendrucks nach wie vor eine große Bedeutung beigemessen.

Allen Glaukom Erkrankungen ist gemein, dass im Verlauf der Erkrankung eine Aushöhlung des Sehnervs (Papillenexkavation) am Eintritt in den Augapfel festgestellt werden kann. Maßgeblich wird dies durch Bildgebende Verfahren wie der Opthalmoskopie (Funduskopie), oder der optischen Kohärenz-Tompgraphie (OCT) diagnostiziert.

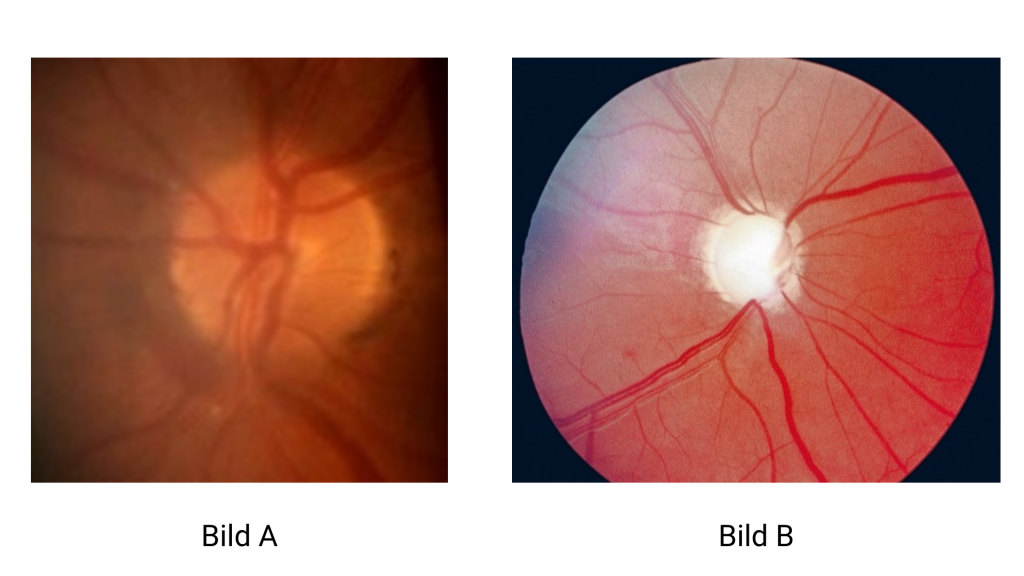

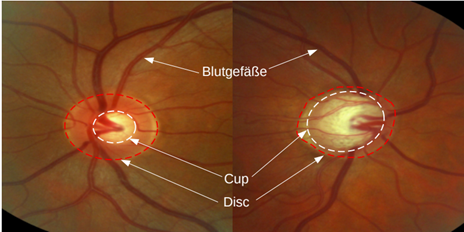

Die Funduskopie oder auch Augenspiegelung ist ein Bildgebendes Verfahren, bei dem der Augenhintergrund des inneren Auges mit Hilfe eines Hohlspiegels aufgenommen wird. Das folgende Bild zeigt eine typische Funduskopie eines gesunden Auges (Bild A) und eines Glaukoms im fortgeschrittenen Stadium (Bild B).

So ist auf Bild B eine deutliche Papillenexkavation des Sehnerves zu sehen. Was an den Bajonettartigen Abknickenden Blutgefäße erkennbar wird. Auf einem OCT (Bild C) dagegen stellt sich das Bild von der Seite dar, und zeigt ebenfalls eindrucksvoll die Degeneration des Sehnervs.

Diese Papillenexkavation stellt auf Basis der OCT oder der Funduskopie ebenfalls ein wichtiges Diagnosemerkmal dar. Hierbei wird meist auf Basis der Funduskopie ein Cup-to-Disc Ratio berechnet welches ein weiterer aussagekräftiger Indikator für eine Glaukom Erkrankung ist.

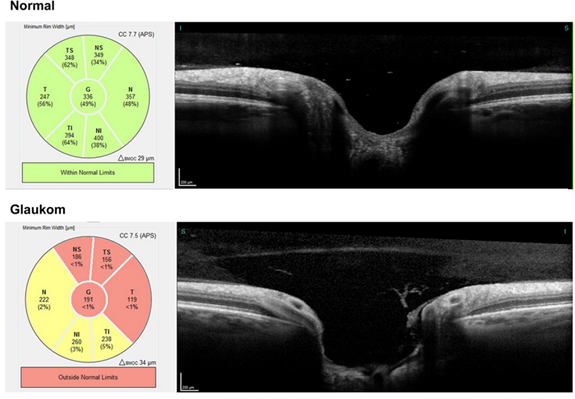

Folgendes Bild illustriert hierbei dieses Cup-Disc Ratio.

Der relevante Bereich für die Glaukomdiagnose befindet sich um den Sehnervenkopf. Dieser gliedert sich grob in zwei Sektionen. Der Sehnervenkopf (Disc) und die Aushöhlung in dessen Zentrum (Cup).

Generell gilt: Eine größere Aushöhlung ergibt ein höheres Cup-Disc Verhältnis und erhöht die Wahrscheinlichkeit für eine Glaukom Erkrankung. Allgemein geht man davon aus, dass ab einem Wert von 0.4 bis 0.7 ein erhöhtes Risiko für ein Glaukom besteht.

Auf Basis der beschriebenen Bildgebenden Verfahren setzt die Deep Learning gestützte Diagnose des Glaukoms an.

Was ist nun Deep Learning?

Das Deep Learning ist heute durch den erneuten Siegeszug der künstlichen Intelligenz in aller Munde. Hierbei werden künstliche neuronale Netze (KNN) verwendet, um auf Basis von Bildern Merkmale (Features) zu erkennen bzw. zu „erlernen“ und daraus Erkenntnisse abzuleiten, um eine Entscheidungsgrundlage zu bilden. Im Fall des Glaukoms, ob Patient an einem Glaukom erkrankt ist oder nicht oder wie wahrscheinlich eine Erkrankung vorliegt.

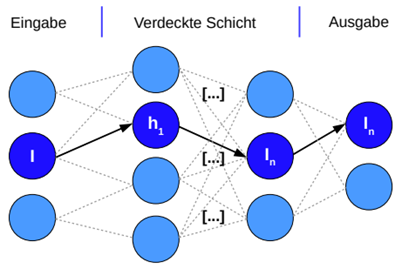

Folgendes Bild zeigt die schematische Darstellung eines einfachen künstlichen neuronalen Netzes KNN, bzw. Multilayer Perzeptron mit einer binären Ausgabeschicht.

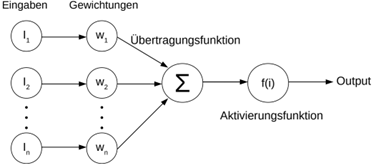

Kleinstes Element eines KNN’s ist dabei ein künstliches Neuron. In seiner Funktionsweise ähnelt ein künstliches Neuron in der Funktionsweise seinem biologischen Pendant im Gehirn. Grundsätzlich kennzeichnet die Funktionsweise von beiden, dass sie in der Lage sind, mehrere Eingaben (Reize) zu verarbeiten, unterschiedlich zu gewichten und anschließend an eine Aktivierungsfunktion zu übergeben und anschließend darauf zu reagieren. Folgendes Bild zeigt den schematischen Aufbau eines solchen Neurons. Beispiele für Aktivierungsfunktionen sind Sigmoid, ReLU, TanH, Softmax oder Softplus.

Eine Aktivierungsfunktion bestimmt den Wertebereich der Aktivierung eines künstlichen Neurons. Diese wird angewandt auf die Summe der gewichteten Eingangsdaten des Neurons. Dabei zeichnet sie sich durch die Eigenschaft der Nicht-Linearität aus. Ohne die Anwendung einer Aktivierungsfunktion wären die einzigen Operationen bei der Berechnung der Ausgabe eines Multilayer Perceptrons die linearen Produkte zwischen den Gewichten und den Eingabewerten. Hintereinander ausgeführte, lineare Operationen können als eine einzige lineare Operation angesehen werden.

Die Anwendung der nicht-linearen Aktivierungsfunktion führt dagegen zu einer Nicht-Linearität des künstlichen neuronalen Netzes und damit zu einer Nicht-Linearität der Funktion, die das neuronale Netz approximiert.

Wozu braucht ein neuronales Netz denn jetzt eine Aktivierungsfunktion? Um interessante Dinge berechnen zu können, müssen neuronale Netze in der Lage sein, nicht lineare Beziehungen zwischen Eingabevektoren x und Ausgaben y zu approximieren. Je komplexer die Daten sind, aus denen wir etwas zu lernen versuchen, desto „nicht linearer“ ist in der Regel die Abbildung von x auf y.

Ein neuronales Netz, dass keine Aktivierungsfunktion in der versteckten Schicht aufweist, wäre nicht in der Lage, solche komplexen Beziehungen mathematisch zu realisieren.

Der “Lernprozess” eines KNN

Ein Neuronales Netz wird, um seine Entscheidungsgrundlage aufzubauen, mit geeigneten Daten trainiert. Diese Daten könne im Falle der Handschrifterkennung unterschiedlich geschriebene Buchstaben und Ziffern sein, oder im Falle des Glaukoms Fundusaufnahmen des Auges.

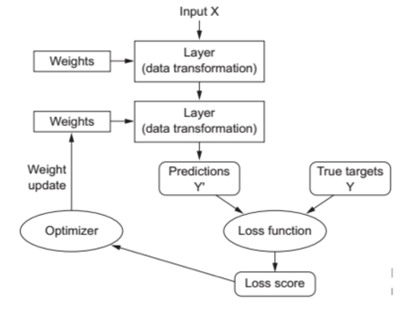

Ein typischer Trainingsprozess sieht folgendermaßen aus:

- 1

Die Eingabedaten werden in einer Trainingsschleife in den Hidden Layer verarbeitet. Die initialen Gewichtungen werden vor Beginn zufällig bestimmt. Ein Durchlauf beinhaltet die stapelweise (engl.: Batch) Verarbeitung aller Trainingssamples. Dazu werden die Trainingssamples in einer vordefinierten Größe von Stapeln eingeteilt. Die Größe der Stapel liegt im Bereich von 1 bis 2n, wobei in der Praxis der zur Verfügung stehende Speicher den limitierenden Faktor darstellt. Die Stapelgröße bestimmt die Anzahl der Trainingssamples, die das Netz verarbeitet, bevor die internen Parameter wie Gewichtungen angepasst werden. Anders ausgedrückt: Das Netz lernt mit einer Stapelgröße von 2n, die Merkmale aus 2n Samples gleichzeitig, bevor es dieses Wissen zur weiteren Anwendung abspeichert.

- 2

Anschließend wird der Verlustwert gebildet und die Gewichtungen nach jedem Stapel angepasst. Die Anpassung erfolgt dabei mit Ziel der Verringerung des Verlustwertes.

- 3

Ein Optimierer ermittelt anhand der Verlustfunktion, wie die Gewichtungen aktualisiert werden. Hierzu implementiert dieser eine bestimmte Variante des stochastischen Gradientenabstiegsverfahrens (SGD). Das Verfahren führt anschaulich dazu, dass an einem Punkt X einer mathematischen Verlustfunktion der steilste Abstieg zu einem lokalen Minimum gesucht wird. Das „stochastisch“ in der Bezeichnung bezieht sich auf das zufällige Auswählen der kleinen Datenstapel. Mit der Fehlerrückführung (Backpropagation) wird durch die Verlustfunktion auf Basis der Ergebnisse des Netzes ein Verlustwert in Abhängigkeit vom tatsächlichen Wert erzeugt. Die tatsächlichen Werte sind Bestandteil der Eingabedaten. Der Verlustwert dient im Anschluss als ein Feedback-Signal zum Anpassen der Gewichtungen in den Layern. Abbildung 7 zeigt das Verfahren in vereinfachter Darstellung.

- 4

Im letzten Schritt werden die Parameter, in der dem Gradienten entgegengesetzten Richtung angepasst. Als Ergebnis sinkt der Wert der Verlustfunktion für diesen Datenstapel etwas. Daraufhin werden die Gewichte in den Layern entsprechend angepasst. Durch Anwendung des Verfahrens wird in weiteren Durchläufen der Verlustscore zunehmend minimiert. Die Trainingsschleife endet nach einer meist vordefinierten Anzahl an Durchläufen. Bei einem neuronalen Netz mit minimaler Verlustfunktion liegen die berechneten Ausgabewerte eng an den tatsächlichen Werten. Man spricht in dem Fall von einem trainierten neuronalen Netz.

Je nach Anwendungsfall haben sich unterschiedliche neuronale Netze und Architekturen etabliert. So gibt es zum Beispiel das Long-Short-Term Memory (LSTM), Generative Adversial Networks (GAN) oder derzeit durch ChatGPT sehr populär gewordene Transformer Network.

Im Bereich der Bilderkennung werden umfangreiche „Convolutional Neural Networks“ modelliert, die mit zahlreichen Zwischenschichten („Hidden Layers“) algorithmisch auf Basis der Backpropagation mit Hilfe des Gradientenabstiegverfahrens diese Merkmale (Features) erlernt. Hierbei haben sich unterschiedliche Frameworks und Bibliotheken etabliert wie z.B. Tensorflow oder Keras.

Diesen und der eigentlichen Modellarchitektur zur Glaukom Erkennung wenden wir uns aber im 2. Teil der Blogserie zu.

Quellen:

Gartner Forecasts Worldwide IT Spending to Grow 8% in 2024 Gartner Forecasts Worldwide IT Spending to Grow 8% in 2024

Holger Schmidt Peter Buxmann. Künstliche Intelligenz – Mit Algorithmen zum wirtschaftlichen Erfolg. 1. Aufl. Seite 21. Springer Gabler, 2019.

European Commission. “Weissbuch Zur Künstlichen Intelligenz – ein europäisches Konzept für Exzellenz und Vertrauen”. In: Weissbuch Zur Künstlichen Intelligenz – ein europäisches Konzept für Exzellenz und Vertrauen (2020). url: https://www.coliquioinsights.de/aerzte-unter-zeitdruck/.

Destatis. “Fallpauschalenbezogene Krankenhausstatistik (DRGStatistik) Operationen und Prozeduren der vollstationären Patientinnen und Patienten in Krankenhäusern”. In: Deutsches Statistisches Bundesamt (2018). url: https://www.destatis.de/DE/ Themen / Gesellschaft – Umwelt / Gesundheit / Krankenhaeuser / Publikationen/Downloads-Krankenhaeuser/operationen-prozeduren5231401187014.pdf?__blob=publicationFile

- LeCun et al. “Handwritten digit recognition with a back-propagation network”. In: Neural Netwotks, current applications”, year = 1992, editor = Lisboa P.G.J., publisher= Chappman and Hall

Alexander Renz “Diagnose von Augenerkrankungen unter Einsatz des maschinellen Lernens“ 17.August 2020

“Automated classification of physiologic, glaucomatous and 2 glaucoma-suspected optic discs using machine learning”

Raphael Diener, Alexander W. Renz, Florian Eckhard, Helmar Segbert, Nicole Eter, Arnim Malcherek, Julia Biermann